Sono “giovane” nel mondo dell'OSINT e tutto mi affascina e mi incuriosisce...

Nel mio navigare sul Web sono approdato, ormai in tarda notte, alla pagina di Digital Methods Initiative: un gruppo di ricerca olandese che collabora con numerose Università europee ed extraeuropee e organizzazioni dai nomi importanti

Sul loro sito Web sono presenti due sezioni particolarmente interessanti: la parte dedicata alle numerose pubblicazioni accademiche e quella riservata ai “Tools” per l’analisi di metadati, social network ed altri vari diabolici aggeggi che non vi elenco sia per non farvi perdere il piacere dell’esplorazione sia perché, secondo me, merita perderci un po' di tempo…

Tra i tools presenti voglio parlarvi di "TCAT" destinato all'acquisizione ed analisi di dati provenienti da Twitter.

Introduzione

TCAT della Digital Methods Initiative (DMI) , come già accennato, permette di acquisire ed analizzare quantità importanti di dati ottenuti da Twitter tramite API, a differenza di quanto faccia Twint che preleva i dati tramite scraping della parte web del sito.

Funzionamento

Il tool opera in due fasi distinte:

- CATTURA: le richieste possono essere perfezionate tramite query di ricerca per parola chiave, hashtag, coordinate geografiche o per utente;

- ANALISI: i risultati possono essere analizzati in varie modalità e ulteriormente filtrati, principalmente mediante l'emissione di file in formati standard CSV e GEXF per eseguire direttamente l’importazione su Gephi.

Di tale software, la DMI ha rilasciato il codice sorgente su GitHub per far si che possa essere installato su Ubuntu 16 o 14.

Contrariamente a quanto dagli stessi autori prescritto, ho provato a installare il tools su Ubuntu 18 e la stessa non è andata a buon fine.

Ho poi eseguito l'installazione di TCAT su una virtual machine di Ubuntu 16.0.4 usando VirtualBox, seguendo questi passaggi:

# sulla macchina appena creata non sarà presente curl quindi lo installeremo con questo comando: <br>$ sudo apt-get install curl<br><br># subito dopo potremo scaricare dalla repo il file "tcat-install-linux.sh" <br>$ curl -O "https://raw.githubusercontent.com/digitalmethodsinitiative/dmi-tcat/master/helpers/tcat-install-linux.sh"<br><br># ...e lo rendiamo eseguibile <br>$ chmod a+x tcat-install-linux.sh<br> <br>#adesso l'installazione è pronta per essere avviata<br>$ sudo ./tcat-install-linux.sh <br>

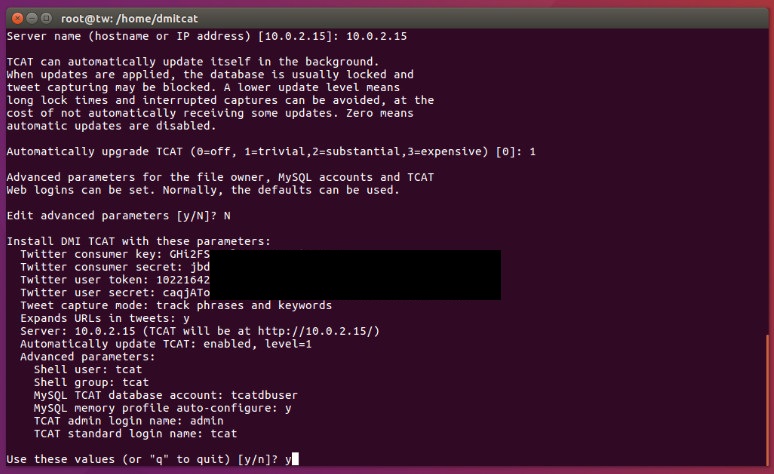

Durante l’installazione verranno chieste come prima cosa le API di Twitter e successivamente altri parametri di configurazione.

Per chiarezza riporto la schermata riepilogativa della configurazione di TCAT eseguita sulla mia VM:

In tale fase verrà chiesto anche il tipo di “capture mode” da eseguire una volta installato TCAT, vale a dire la tipologia di acquisizione dei dati, che può avvenire in 2 modalità:

- tramite frase e/o parola chiave o geolocalizzando un area;

- tramite l’user.

Per comodità ho approntato due macchine virtuali con i due “capture mode” sopra indicati che uso con differenti API.

Una volta terminato lo script di installazione il terminale ci riassumerà i parametri di accesso:

Done: TCAT installed<br>Please visit this TCAT installation at these URLs:<br>http://10.0.2.15/capture/ <br>http://10.0.2.15/analysis/<br>TCAT administrator login (for capture setup and analysis):<br>Username: admin <br>Password: qUQQrQ----------------------------------<br>TCAT standard login (for analysis only):<br>Username: tcat <br>Password: fE882-------------------------------------<br>IMPORTANT: please save the above generated TCAT Web login passwords.<br>MySQL accounts have been saved to /etc/mysql/conf.d/tcat-*.cnf.<br>The following steps are recommended, but not mandatory

Consiglio vivamente di salvare le password di accesso!

Da adesso in poi inizia il divertimento ;-)

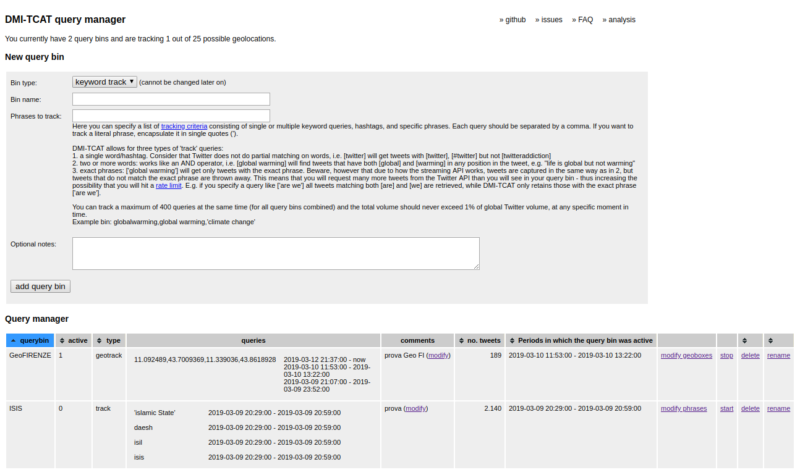

Per eseguire TCAT servirà digitare sulla barra di ricerca di un browser il link riportato sopra http://10.0.2.15/capture/ ed inserire user e password fornite, fatto ciò si aprirà la dashboard:

Cambiando il tipo di cattura da “keyword track” a “geo track” la legenda della dash varierà ma sarà sempre precisa e puntuale nella descrizione dei comandi da inserire.

Nel mio caso ho effettuato delle prove di cattura eseguendo una query per parola chiave denominata “ISIS” ed una query di georeferenziazione inserendo dati GPS inerenti la provincia di Firenze.

ANALISI del metodo di lavoro:

- L’interrogazione per keyword mi ha dato subito molti risultati, come era prevedibile, vista la query molto “popolare”.Ho dovuto quindi interrompere la sua esecuzione. Procedendo con altre prove ho inserito parole in lingua araba ed il programma ha eseguito sempre il mining dei tweet.

- La “geo track” ha fornito meno quantità di dati ma, come viene specificato dalla legenda, i risultati che Twitter resituirà non saranno solamente quelli che l'utente decide di condividere impostando "usa la mia posizione" ma anche quelli che Twitter può decidere di utilizzare mediante acquisizione indirizzi IP per determinare la posizione. Se un utente decide poi di aggiungere ad un Tweet un luogo specifico questo verrà memorizzato nei dati acquisiti se il luogo si trova all'interno della zona geografica oggetto di indagine.

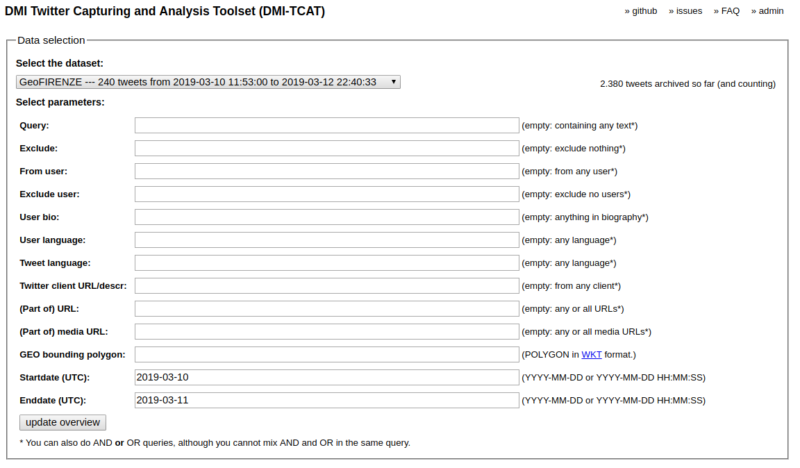

Per visualizzare i risultati della cattura basta semplicemente andare al link http://10.0.2.15/analysis/ oppure cliccare in alto a destra sull'opzione “Analysis” della maschera "DMI-TCAT query manager":

Come si può ben vedere i dati possono essere ulteriormente filtrati applicando altri parametri definiti dall’analista.

Dai dati estratti il tool permette di effettuare 3 principali operazioni:

- un' analisi di tipo statistico che comprende numerosissime opzioni;

- operazioni sugli user, sui tweet e sugli hashtag;

- estrazione dei dati di interesse in formati tali da poter essere letti da software per l'analisi e la visualizzazione delle reti sociali, come ad esempio Gephi;

- una parte di analisi sperimentale.

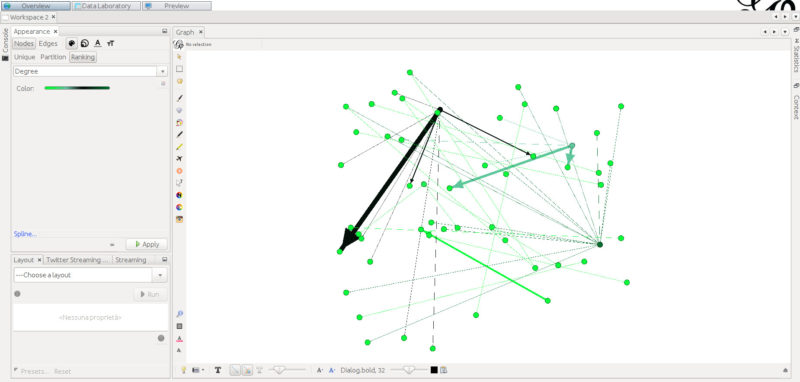

Il download del set di dati di interesse è eseguito in files .csv o .tsv sempre ben organizzati. Anche l’esportazione e l’importazione in Gephi è sempre molto efficiente, come si può vedere nello screenshot seguente, ma ciò potrebbe essere oggetto di un prossimo articolo...

Spero di non avervi annoiato preso com'ero a sperimentare...In men che non si dica si è fatta nuovamente notte fonda ancora immerso nell'affascinante mondo dell’OSINT.

****NDR: al momento non so se si puo’ cambiare il “capture mode” una volta terminata l’installazione ******

Tags:

March 18, 2019

Comments